ローカルLLMをmacOS環境にインストールする

ローカル LLM は、パソコンやサーバー上で直接実行可能な大規模言語モデル(LLM)です。ChatGPT などのクラウドサービス型 LLM とは対照的に、データ処理と推論をオフラインで実行するため、プライバシー・セキュリティ・レイテンシの面で優位性があります。例えば、機密性の高い研究データを扱う場合、外部サーバーへのデータ送信が不要となので、情報漏洩のリスクを低減できます。

近年、ハードウェア性能の向上とモデルの軽量化が進み、ローカルLLMの導入が現実的な選択肢となってきました。以前は、LLMの実行には高度な計算リソースが不可欠でしたが、CPUやGPUの性能向上に加え、量子化や蒸留といったモデル圧縮技術の進展により、比較的小規模な計算機資源でもローカルLLMの実行が実現可能となっています。

このノートでは、 Ollama と Open WebUI を用いて、macOSマシン上にローカルLLM環境を構築し、 Phi-4 , Gemma 3 , DeepSeek R1 といった軽量かつ高性能なモデルを利用できるようにする手順を説明します。

必要条件の確認

このノートは、Apple Silicon チップを搭載した macOS 環境での動作を前提としています。

前提条件

Ollama の導入

Ollama は、ローカル環境で LLM を実行するためのエンジンです。モデルの取得から実行までをお手軽に行うことができます。

インストール手順

brew install ollamaインストール後、Ollama を起動します。

ollama serve初回起動時には、自動的にバックグラウンドで Ollama サービスが立ち上がります。

Ollama をサービスとして常駐させる(自動起動)

Ollama を常にバックグラウンドで実行しておきたい場合は、brew services を使ってサービスとして登録することができます。

サービスを起動する:

brew services start ollamaサービスを停止する:

brew services stop ollamaサービスを確認する:

brew services listモデルのインストール

次に、使用するLLMをインストールします。ローカル環境で利用可能なオープンソースモデルとしては、例えば、以下のものが挙げられます。

- Phi-4 14B (Microsoft社が開発した140億パラメータの軽量モデル)

- Gemma 3 27B (Google社が開発した軽量モデル。マルチモーダル処理が可能)

- DeepSeek R1 Distill Qwen2.5 Bakeneko 32B (DeepSeek開発の推論モデルを元に日本語思考能力を強化したもの)

これらのモデルは、それぞれ以下のコマンドでダウンロードできます。

ollama pull phi4ollama pull gemma3:27bollama pull hf.co/mmnga/cyberagent-DeepSeek-R1-Distill-Qwen-32B-Japanese-ggufモデルを実行してみる

以下のコマンドを実行すると、LLM との対話モードを開始できます。

ollama run phi4>>> 量子化学計算について教えて

もちろんです!量子化学計算は、分子や物質の電子構造を解析するための数値的手法です。この分野では、ボルン-オッペンハイマー近似や密度汎関数理

論(DFT)などの基礎となる理論を用いて、量子力学的手法で化学系の性質を予測します。以下にその主要な側面を説明します。

### 1. **ボルン-オッペンハイマー近似**

これは多電子システムを扱うための基礎的なアプローチで、全体の波動関数が単純化されます。具体的には、複雑な多電子問題を一連の一電子問題とし

て近似し、分子軌道(MO)法や密度汎関数理論で計算することが可能になります。

### 2. **ハートリー-フォック法**

これはボルン-オッペンハイマー近似を実現するための具体的な方法です。自己無撞着場(SCF)手順を用いて、分子軌道における電子密度が一貫性を持

つように求めます。

### 3. **配置相互作用法(CI法)**

ハートリー-フォックの結果から始まり、基底状態と励起状態の両方を考慮して精度を向上させます。全電子相互作用をより正確に捉えることができます。

### 4. **Møller-Plesset展開(MPn法)**

ハートリー-フォックの解から出発し、摂動理論に基づいて相互作用を追加的に考慮します。特にMP2は第二次摂動として広く利用されます。

### 5. **密度汎関数理論(DFT)**

DFTでは、電子の分布自体を扱うことで計算を効率化します。ユニークな汎関数が存在し、その選択によって結果の正確性が左右されます。多くの現代的

な計算ではDFTが用いられています。

### 6. **ソフトウェア**

量子化学計算は、Gaussian, ORCA, VASPといった専門ソフトウェアを通じて実行されます。これらのプログラムは、上記の理論や手法を用いて分子の性

質を計算します。

### 7. **応用**

量子化学計算は多岐にわたる研究分野で利用されます。新材料の設計、薬剤開発、触媒反応の解析などが主要な例です。

これらの手法は相互に補完的であり、問題の性質や必要とされる精度によって最適な方法を選択します。量子化学計算は計算能力が向上するにつれて、

さらに発展し続けています。Open WebUI の導入 (GUI フロントエンド)

Open WebUI は、Ollama をバックエンドとして利用し、ブラウザ上でLLMと対話するためのインターフェースを提供する Web アプリです。ここでは、Docker を用いたインストール方法について説明します。

インストール手順

まず、 Open WebUI の Docker イメージをダウンロードします。ターミナルで以下のコマンドを実行してください。

docker pull ghcr.io/open-webui/open-webui:main次に、以下のコマンドを実行して Open WebUI を起動します。

docker run -d \

--name open-webui \

-p 3000:8080 \

--add-host=host.docker.internal:host-gateway \

-v open-webui:/app/backend/data \

--restart always \

ghcr.io/open-webui/open-webui:main起動後、Web ブラウザで http://localhost:3000 にアクセスすると、Open WebUI のインターフェースが表示されます。

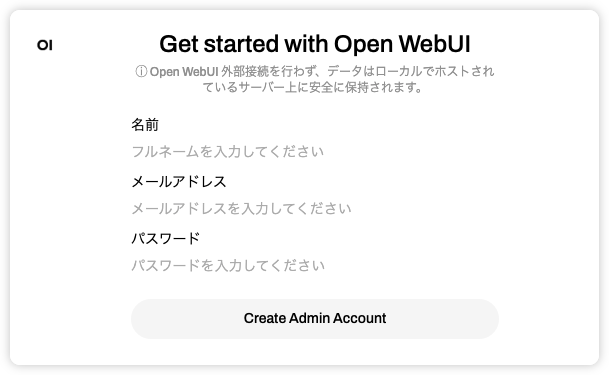

アカウントの作成

Open WebUI 最初にアクセスすると、下記のような画面が表示されるので、管理者用のアカウントを作成します。

モデルを実行してみる

まとめ

ローカル LLM を使えるようになることで、セキュリティーとコストを気にせずに使えるようになる点は魅力的ですね。

また、自分でいろいろなモデルをインストールして試してみることは、LLM の使いどころや内部の仕組みについて、より深く理解するためのきっかけになるのでは。

Let’s enjoy local LLM!